Digital Services Act (DSA), på svenska ”Rättsakten om digitala tjänster”, är ett lagpaket från EU-kommissionen. Målsättningen är att skapa nya förutsättningar för mellanhänder på internet, anpassade efter de senaste tjugo årens utveckling. Stora, viktiga frågor om mellanhänders juridiska ansvar för användares kommunikation, särskilda krav på dominerande plattformar och eventuella filter av allt på internet kommer avgöras i DSA.

Digital Services Act kommer vara en av de viktigaste, mest fundamentala lagpaketen för vår digitala framtid, med konsekvenser för internet och vårt samhälle i flera decennier framåt.

Här går vi ganska noggrant igenom vad kommissionens förslag till DSA innehåller, med reservation för att vi inte är jurister och säkert kan ha missförstått något här och var, och för att vi utelämnat vissa mindre intressanta delar. Vill du ha sammanfattningen kan du gå till vår översiktssida om DSA.

Här kan du läsa hela kommissionens förslag.

Vi återkommer med mer ingående analyser av vad som ingår i DSA-förslaget, men kanske framför allt vad som inte ingår i det, som till exempel rätt till anonymitet, skydd för kryptering och förbud mot uppladdningsfilter.

Inledande bestämmelser och definitioner

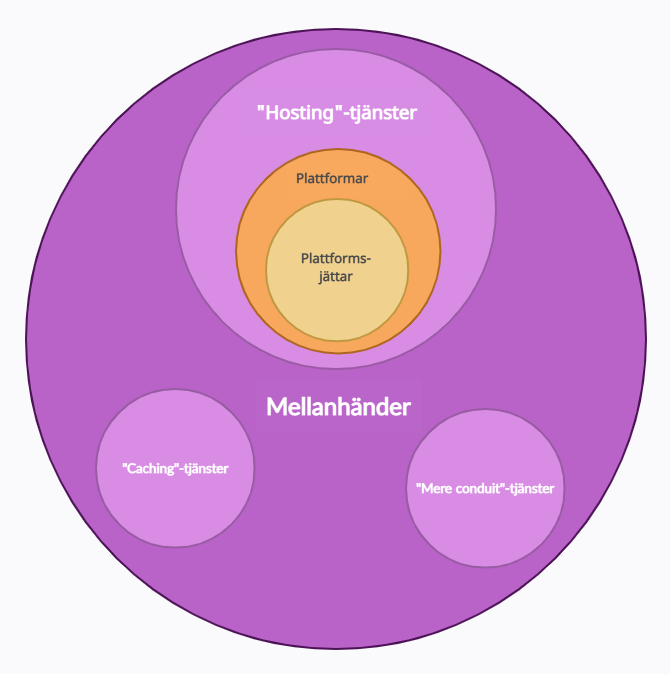

>Dessa tre kategorier är samma tre som omfattas av e-handelsdirektivets paragraf om Safe Harbor, och omfattar ungefär (i) internetoperatörer, (ii) mailleverantörer och (iii) molntjänster.

Plattformar (”online platforms”) definieras som en ”hosting service” (se (iii) ovan), som åt sina användare lagrar och tillgängliggör information till allmänheten – så länge detta inte bara är en bieffekt av den tjänst som erbjuds. Att tillgängliggöra information för allmänheten (”dissemination to the public”) definieras som att göra det möjlighet för en potentiellt obegränsad mängd personer att komma åt informationen.

Reklam definieras som information som en naturlig eller juridisk person betalat för att sprida – oavsett syfte med denna information. Det omfattar alltså även propaganda för till exempel politiska åsikter.

Rekommendationssystem (”recommender system”) definieras som ett åtminstone delvis automatiserat system för att föreslå och ranka information till användare av en plattform – både vid sökningar och vid bläddring i någon form av feed.

Budbärarimmunitet – nättjänsters ansvar för sina användares brott

>Detta undantag från juridiskt ansvar gäller inte när användaren av tjänsten styrs (”is acting under the authority of or the control”) av den som äger tjänsten.

Ett andra undantag finns gällande konsumentskyddslagar, där plattformar (en delmängd av ”hosting”-tjänster) som tillåter konsumenter att sluta kontrakt med tredje parter, ifall en rimligt insatt konsument har svårt att skilja den tredje parten från plattformen själv.

Myndigheters möjlighet att begära borttagande av information

>Med andra ord kan inte stater kräva att tjänsteleverantörer kontinuerligt granskar ifall någon användare begår ett brott. Intressant nog kan artikel 1 tolkas så att undantag från denna regel gäller för TERREG och upphovsrättsdirektivet.

Myndigheternas order måste innehålla belägg för att informationen är illegal, med hänvisning till lagrum.

Dessutom får ordern bara begära sådan information som mellanhanden redan samlat in för andra syften.

Due diligence-krav på mellanhänder

>Mellanhänder får inte upprätthålla dessa avtal hur som helst, utan måste agera ”diligent, objective and proportionate” i sin tillämpning av avtalstexten. Dessutom måste de ta användarnas rättigheter i åtanke.

Mest intressant är kanske kravet på att vara transparenta i vilken moderering man själva gjort. Mellanhänder ska berätta ”the number and type of measures taken that affect the availability, visibility and accessibility of information” som användare lagt ut.

Ett undantag införs här för mellanhänder som kvalificerar sig som mikro- eller småföretag enligt 2003/361/EC (färre än 50 anställda och mindre än tio miljoner euro i omsättning eller tillgångar).

Due diligence-krav på ”hosting”-tjänster (inklusive plattformar)

>Följande ska inkluderas: (i) en förklaring av varför informationen anses vara illegal, (ii) URL till informationen, (iii) identifierande information om informatören, och (iv) försäkran om att man lämnat korrekt och fullständig information.

Den mellanhand som mottar en sådan information ska anses ha kännedom om brott enligt artikel 5.

Mellanhänder ska processa sådana krav snabbt och grundligt. Om de gör detta på automatisk väg ska information om detta framgå i meddelande till berörda parter.

Due diligence-krav på plattformar (men inte andra ”hosting”-tjänster)

>Om överklagan innehåller information som gör att tidigare beslut framstår som felaktigt, ska plattformen backa från sitt tidigare beslut.

Beslut om överklagan får inte tas på (helt) automatisk väg.

Användare som påverkats av plattformars beslut att ta bort/förhindra tillgång till information ska kunna välja vilken sådan utomrättslig organisation som helst, vilken är certifierad, för att hantera dispyter.

Organisationen får maximalt ta så mycket betalt som proceduren kostat. Om plattformen vinner dispyten behöver inte användaren betala plattformens kostnader, men vice versa gäller inte.

När ”trusted flaggers” begär att material tas ned i enlighet med artikel 14 ska deras krav hanteras skyndsamt och före andras krav.

Kommissionen ska ha en offentlig och uppdaterad databas av alla ”trusted flaggers”.

Om en plattform upptäcker att en ”trusted flagger” upprepat har lämnat felaktiga begäranden ska den informera berörd Digital Services Coordinator, vilken ska undersöka ifall licensen ska dras in.

Personer/organisationer som upprepat skickar ogrundade krav enligt artiklarna 14/17 ska också kunna stängas av på liknande sätt.

Vid avstängning ska plattformen ta hänsyn till hur allvarligt missbruket av tjänsten är, hur många gånger missbruk skett, andel missbruk till normalt bruk och uppsåt.

Plattformen ska göra rimliga ansträngningar för att kontrollera så att lämnad information är pålitlig.

Informationen ska tas bort när försäljaren slutar använda plattformen.

Due diligence-krav på plattformsjättar (men inte andra plattformar)

>Särskild hänsyn ska tas till deras system för moderering, rekommendationer och reklamvisning.

Granskningsrapporter ska publiceras med slutsatser, metodologi och avgörande om huruvida jätten följt kraven i DSA.

Om granskningen kommer fram till att jätten inte följt kraven ska den lämna rekommendationer, som jätten ska ta hänsyn till inom en månad, varefter rapport ska lämnas om vad de gjort och varför.

Användaren ska ha minst ett alternativ till rekommendationssystem som inte grundas på profilering.

Finns mer än ett alternativ till rekommendationssystem ska det vara enkelt för användare att byta mellan dem.

Jättar ska också överlämna information till forskare på systemiska risker (artikel 26), när Digital Services Coordinator ber om det.

Lite allmän byråkrati

>Digital Services Coordinators (DSC)

>De ska också kunna dela ut böter i enlighet med artikel 42 och utfärda order om att avbryta brott mot DSA.

De ska kunna – vid särskilda omständigheter – begära av domstol att beordra blockering av tillgång till tjänster som bryter mot DSA.